Durch die Verarbeitung grosser Mengen unstrukturierter qualitativer Daten kann generative KI differenzierte Analysen und Berichte erstellen und so Zeit und Kosten erheblich reduzieren. Die Technologie eignet sich hervorragend für Aufgaben wie die Analyse und Zusammenfassung von qualitativen Interviews und Gruppendiskussionen. Generative KI hat jedoch Schwierigkeiten, strategische Schlussfolgerungen auf den Punkt zu bringen; eine Aufgabe, die am besten weiterhin erfahrenen Forschenden überlassen wird. Mit dem «ChatYourData»-Ansatz lassen sich qualitative Daten unmittelbar in Produktinnovationen oder Kommunikationskonzepte umsetzen. Die generative KI verspricht, qualitative Erkenntnisse wettbewerbsfähiger und zugänglicher zu machen, und könnte so zum Game-Changer für die Markt- und Sozialforschung werden.

Die Rolle der generativen KI in der der qualitativen Markt- und Sozialforschung

Mit der Veröffentlichung von ChatGPT im Herbst 2022 sind die Möglichkeiten der generativen KI einer breiten Öffentlichkeit bewusst geworden. Insbesondere die Leistungen der hochentwickelten Sprachmodelle (Large Language Models) beim Schreiben und Redigieren von Texten sind auf den ersten Blick erstaunlich. In der qualitativen Markt- und Sozialforschung steht die Sprache im Zentrum – in Form von Tiefeninterviews, Gruppendiskussionen oder anderen digitalen Formen des Dialogs. Die aktuelle Generation der generativen KI ist deshalb prädestiniert, qualitative Forschung voranzubringen. Entsprechende Methoden nutzen auch projektive Verfahren wie Visualisierungen, um ein vertieftes Verständnis von Emotionen und Einstellungen zu gewinnen. Die Übersetzung von Sprache in Bilder und umgekehrt ist die Stärke von visuellen generativen Modellen wie Dalle, Midjourney und anderen.

Die qualitative Markt- und Sozialforschung ist eine unverzichtbare Ergänzung zur besser bekannten und viel häufiger eingesetzten strukturierten («quantitativen») Umfrageforschung. Die qualitative Forschung ist explorativ und ermöglicht es den Teilnehmenden, ihre Gedanken und Gefühle in ihren eigenen Worten auszudrücken. Dies kann zu Erkenntnissen führen, die in einer strukturierten Umfrage vielleicht nicht erwartet oder erfasst worden wären. Qualitative Erkenntnisse liefern Erklärungen zum «Wie?» und «Weshalb?» hinter den quantitativen Zahlen.

Bisher hatte die qualitative Markt- und Sozialforschung den Ruf, zeitaufwändig und teuer zu sein. Durch die Nutzung von generativer KI kann sie nun effizienter, schneller und besser werden. Dies wird zu einem Revival der qualitativen Methoden führen.

Dieser Artikel untersucht die potenziellen Verbesserungen und Herausforderungen von generativer KI in der qualitativen Verbraucherforschung und konzentriert sich dabei auf die konkreten Anwendungen.

Was ist generative KI?

Generative KI bezieht sich auf eine Teilmenge von Technologien der künstlichen Intelligenz, die neue Inhalte generieren können, einschliesslich Text, Bild und Audio. Generative KI gibt es schon lange. Bereits im letzten Jahrhundert wurden Versuche gestartet mit Computern, die eine menschenähnliche Fähigkeit zur Konversation beherrschten. Der aktuelle Durchbruch ist auf Fortschritte in der Hardware, in den theoretischen Konzepten und in den eingesetzten Algorithmen zurückzuführen.

Neue theoretische Konzepte

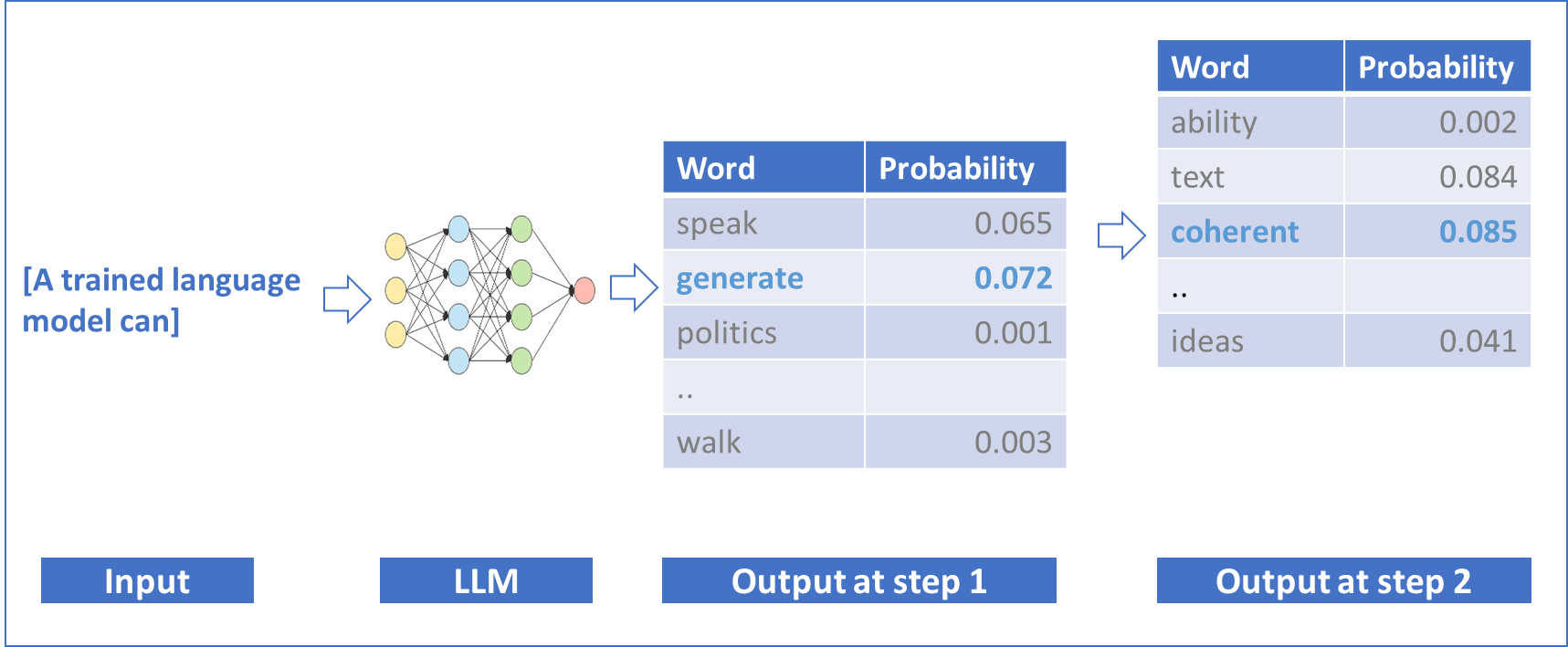

Die modernen generativen KI-Modelle fokussieren nicht auf abstrakte grammatikalische und semantische Regeln, sondern darauf, wie Sprache verwendet wird. Zentral ist die Annahme, dass die Bedeutung eines Wortes im Kontext seiner Verwendung liegt. Umgekehrt folgt daraus, dass die Wahrscheinlichkeit eines Wortes aufgrund des Kontextes vorausgesagt werden kann. Dies machen sich die Entwickler der Large Language Models wie OpenAI, Mistral oder Gemini zunutze: Sie trainieren die Sprachmodelle darauf, immer das nächstfolgende Wort eines Satzes oder eines Textes vorherzusagen. Der Vorteil dieses Ansatzes liegt darin, dass für das Training grosse Mengen bestehender Texte verwendet werden können, die nicht manuell vorbereitet werden müssen (kein kostenintensives Labeling bzw. keine Annotation). Der vergleichsweise einfache Ansatz, aus dem Kontext den jeweils wahrscheinlichsten Output vorherzusagen, funktioniert überraschend gut – auch für inhaltlich anspruchsvolle und komplexe Aufgabenstellungen.

Neue Algorithmen

Für das Training werden bewährte Algorithmen in Form neuronaler Netzwerke mit einer hohen Anzahl an Schichten eingesetzt – deshalb auch «Deep Learning» genannt. Der Durchbruch für die generative KI basiert auf einem spezifischen, relativ neuen Typ neuronaler Netzwerke: Transformer Modelle, die in der Lage sind, vergleichsweise lange Textsequenzen parallel zu verarbeiten und gleichzeitig die besonders relevanten Textstellen höher zu gewichten.

Die sogenannten Foundation Models, die einen Satz oder einen anderen Kontext ergänzen können, bilden allerdings nur den ersten Schritt zur Entwicklung eines KI-Sprachmodells. Ein funktionsfähiges Modell, das Fragen beantworten und Anweisungen ausführen kann, braucht weitere Schritte:

indem wir ein Wort nach dem anderen vorhersagen.

In einem zweiten Schritt, dem Instruction Finetuning, wird das Modell darauf trainiert, spezifische Anweisungen zu befolgen, also zum Beispiel eine Zusammenfassung zu erstellen, einen Blog-Artikel zu schreiben oder eine Wissensfrage zu beantworten.

Der dritte Schritt, Reinforcement Learning from Human Input, optimiert die Qualität des Outputs so, dass die Erwartungen der Zielgruppen möglichst gut erfüllt werden. Dazu bewerten Hunderte von Testpersonen die Resultate manuell, was dann wiederum ins Training des Modells einfliesst.

Neue Hardware

Die meisten technologischen Revolutionen der letzten Jahrzehnte basieren wesentlich auf sprunghaften Entwicklungen der Hardware. Bei der generativen KI sind dies neue Prozessoren, die ideal auf die Deep Learning Algorithmen abgestimmt sind, obwohl sie ursprünglich für Bildverarbeitung entwickelt wurden.

Implikationen für die Anwendung in der qualitativen Markt- und Sozialforschung

Das zugrundeliegende «Foundation Modell» einer modernen KI-Lösung basiert auf der beobachteten Verwendung von Sprache, die einerseits sprachliche Fähigkeiten wie Grammatik und Wortschatz, anderseits aber auch das Wissen über die Welt spiegelt. Die sprachlichen Fähigkeiten und das Fachwissen können in diesen Modellen also nicht klar getrennt werden. Das ist ein wichtiger Punkt, wenn wir generative KI, konkret die bekannten Large Language Models, für die qualitative Marktforschung einsetzen wollen.

Nehmen wir an, wir analysieren zum Beispiel Transkripte von Tiefeninterviews zum Thema «Schokolade» mithilfe von generativer KI. Das implizite «Weltwissen» des KI-Modells aufgrund der Trainingsdaten ist dabei immer mit im Spiel. Viele der Trainings-Texte wurden im Internet gesammelt oder stammen und aus digitalisierten Bibliotheken. Im Fall von Schokolade sind zum Beispiel nicht nur der Genuss, sondern auch Aspekte der Gesundheit, der Nachhaltigkeit und des Masshaltens relativ stark im Vorwissen der Modelle verankert.

Das ist an sich kein Nachteil der generativen KI. Tatsächlich ist Sprachverständnis ohne ein Verständnis der Wirklichkeit nicht möglich. Eine qualitative Marktforscherin wird Texte immer auch vor dem Hintergrund ihres Vorwissens analysieren. Entscheidend ist, dies bewusst zu reflektieren. Diese Reflexion fehlt den Sprachmodellen. Um eine angemessene, möglichst unverzerrte Analyse von qualitativen Konsumentenaussagen zu gewährleisten, braucht es also sorgfältig ausgearbeitete Kontrollmechanismen. Unter diesen Voraussetzungen kann KI sogar zu einer besseren Qualität qualitativer Insights beitragen: Forschende mit weniger Erfahrung haben manchmal einen sehr persönlichen Zugang zu den untersuchten Themen und bringen so unbewusst einen starken Bias ein. Bei Large Language Modellen fällt diese persönlich-subjektive Komponente der Analyse weg.

Die Qualität der Zusammenfassung von Transkripten beispielsweise hängt stark davon ab, wie gut das jeweilige Modell genau für diese Aufgabe trainiert wurde (Instruction Finetuning – siehe oben). Bei GPT, Gemini, Mistral, Claude und Llama funktionieren Zusammenfassungen sehr gut. Diese Disziplin beherrschen aber auch viele kleinere, günstigere Modelle.

Etwas anspruchsvoller wird es, wenn bestimmte relevante Themen aus einer Reihe von langen Transkripten extrahiert werden sollen, zum Beispiel die Motive oder die Barrieren des Schokoladekonsums aus mehreren Tiefeninterviews. Die führenden Modelle (GPT-4, Mistral Large oder Anthropic Claude Opus) machen dies ziemlich gut, ohne fremde Informationen aus ihrem impliziten «Wissen» in die Ergebnisse zu schmuggeln.

Auf welche Tasks ein Large Language Modell spezifisch trainiert wurde, ist allerdings oft nicht transparent. Hier hilft nur «Trial and Error», um die besten Lösungen zu identifizieren.

Qualitätskriterien

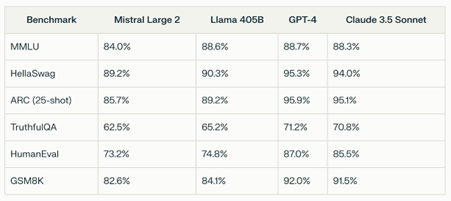

Formale Qualitätskriterien, die für die Überprüfung und Evaluation von Large Language Models entwickelt wurden, sind nur beschränkt hilfreich.

Für die Bewertung der Qualität einer Text-Zusammenfassung gibt es die ROUGE-Metrik (Recall-Oriented Understudy for Gisting Evaluation). Der Score vergleicht eine durch Experten erstellte Referenz-Zusammenfassung mit dem Output eines KI-Modells. Für qualitative Ad-hoc-Studien liegt eine solche Referenz-Zusammenfassung in der Regel nicht vor. Dazu kommt, dass der ROUGE-Score primär die Wörter in den Zusammenfassungen vergleicht und auszählt, was etwas zu kurz greift.

In der Literatur werden oft standardisierte Performance-Messungen für konkurrierende Large Language Models publiziert. Diese Indices basieren auf Wissensfragen, z. B. Prüfungen für amerikanische College-Studierende, «Reasoning» oder dem Schreiben von korrekten Programmier-Codes. Diese Kriterien sagen wenig über die Leistungsfähigkeit im Rahmen von qualitativer Markt- oder Sozialforschung aus.

Beim Einsatz von generativer KI in der qualitativen Forschung muss die Qualität des Outputs vorderhand von der Studienleitung sorgfältig geprüft werden. Wünschenswert wäre die Entwicklung von standardisierten automatisierten Qualitäts-Scores zur Unterstützung. Ein Beispiel dafür wäre ein Vergleich der Topics, die in den Input-Daten aufscheinen, mit jenen in Zusammenfassungen und Interpretationen.

Use-Cases für Marketing und Produktentwicklung

Die möglichen Anwendungsfälle der generativen KI in der qualitativen Markt- und Sozialforschung sind sehr breit. Vieles steckt noch in den Kinderschuhen. Es braucht Zeit und finanzielle Ressourcen, um spezifische Tools zu entwickeln und insbesondere die Qualitätskontrollen zu institutionalisieren. Als Illustration dienen drei konkrete Use-Cases, die der Autor erfolgreich umgesetzt hat. Beim ersten Anwendungsfall geht es um die naheliegende Umsetzung von Effizienz und Zeitgewinn. Der zwei weiteren Use-Cases schauen eher in die Zukunft und sind noch experimentell.

Use Case 1: Generative AI als Forschungsassistentin für mehr Effizienz und Qualität

Im Kontext der Markt- und Sozialforschung ist die generative KI besonders wertvoll aufgrund ihrer Fähigkeit, grosse unstrukturierte Datenmengen zu verarbeiten und nuancierte Analysen und Berichte zu erstellen.

Ein erster Anwendungsfall aus der Praxis illustriert das Vorgehen. Die strategische Fragestellung bestand darin, Erwartungen und Wünsche der Privatkundinnen und -kunden bei der Wahl einer Versicherung zu verstehen.

Als Datengrundlage standen 20 frei geführte Interviews von je ca. 40 Minuten Dauer in Schweizerdeutsch und Französisch zur Verfügung. Die Interviews wurden automatisch transkribiert und durch freie Mitarbeitende manuell nachbearbeitet.

Ziel des Projektes war, die Qualität einer automatisierten Analyse mittels generativer KI einer vorläufigen Prüfung zu unterziehen. Die ursprüngliche Analyse wurde durch erfahrene qualitative Marktforscherinnen mit «manuell» realisiert. Erst zu einem späteren Zeitpunkt wurde die Analyse mithilfe von KI (im Wesentlichen mit dem GPT4-Modell von OpenAI) wiederholt.

Es stellte sich heraus, dass die Themenextraktion (z. B. Bedürfnisse, erwartete Angebots-

merkmale, Wechselgründe) sehr gut funktioniert. Im Vergleich zum manuell erstellten Bericht wurden praktisch 100 % der Themen erkannt und in den Zusammenfassungen erwähnt.

Hochentwickelte Modelle wie ChatGPT4 schaffen auch eine gute, nahtlose Integration der Originalsprachen z. B. in einen englischen Bericht. Dies gilt allerdings nur für weit verbreitete Sprachen – in Europa z. B. Deutsch, Französisch, Italienisch und Spanisch.

Bei der qualitativen Analyse geht es nicht darum, Kategorien oder Themen auszuzählen Dennoch macht es Sinn, typische Argumentationsmuster von vereinzelten Argumenten zu differenzieren. Kann die generative KI bei der Analyse von Themen in einem umfangreichen Text-Datensatz relevante von weniger relevanten Themen unterscheiden? Im Test mit 20 Interviews zum Thema «Versicherung» hat das gut funktioniert.

Die Analyse-Ergebnisse in Reports des Qualitativen Consumer Research werden oft mit wörtlichen Zitaten illustriert. Mit einem entsprechenden Prompt liefert das KI-Modell passende Zitate, die in ca. 80 % der Fälle nicht modifiziert sind. Teilweise werden die Zitate leicht umformuliert. Auch diese zeitaufwändige Aufgabe erledigt die KI also mit hoher Zuverlässigkeit.

KI kann Empfehlungen formulieren. Das Projekt hat allerdings gezeigt, dass die KI kaum in der Lage ist, die entscheidenden Schlussfolgerungen und Insights unter Berücksichtigung der strategischen Fragestellung, der Marktsituation und des Business Modells der Auftraggeberin zu formulieren. Diese Aufgabe sollte unbedingt eine Senior Marktforscherin oder ein erfahrener Insight-Spezialist übernehmen.

Dies ist ganz klar kein Argument gegen den Einsatz von KI in der qualitativen Marktforschung. Die Ergebnisse verschiedener Projekte zeigen, dass – im Vergleich zum bisherigen, vollständig manuellen Vorgehen – 40 bis 60 % des gesamten Zeitaufwandes eingespart wird. Damit macht KI qualitative Consumer Insights für Auftraggeber sowohl in Bezug auf die Kosten wie auch auf eine agile Umsetzung deutlich attraktiver und somit wettbewerbsfähiger.

Use Case 2: Jenseits von statischen Insight-Reports

Consumer Insight Reports verstauben oft im Archiv der Auftraggebenden. Mit generativer KI ergeben sich vollkommen neue, bisher nicht mögliche Wege, um End-Usern einen Mehrwert zu liefern.

Im konkreten Anwendungsfall wurden acht Tiefeninterviews zum Thema «Schokoladekonsum» durchgeführt. Die KI wurde spezifisch darauf trainiert, innovative Produktkonzepte zu entwickeln, die anschliessend in einer strukturierten quantitativen Online-Erhebung validiert werden können.

Das Konzept wurde also durch das KI-Tool unmittelbar auf Basis der ungefilterten Konsumentenbedürfnisse und unter Berücksichtigung der Sprache der Konsumentinnen und Konsumenten erstellt. Im Test hat die KI plausible, klar formulierte Konzepte entwickelt, die auf relevanten Konsumentenerwartungen aufbauen. Inwieweit diese Ideen bei den Zielgruppen besser oder mindestens gleich gut abschneiden wie von Expertinnen formulierte Konzepte, ist in einem weiteren Schritt zu prüfen.

Durch diesen «Prompt Your Data»-Ansatz gewinnen qualitative Konsumentendaten enorm an Wert. Die Daten können jederzeit auf aktuelle Hypothesen und Innovationsideen abgefragt werden. Die Daten stehen live als «Voice of Consumer» zur Verfügung, ohne Informationsverlust durch Zusammenfassung in einem statischen Bericht.

Use-Case 3: Neutrales Nachfassen bei offenen Fragen in Online-Interviews

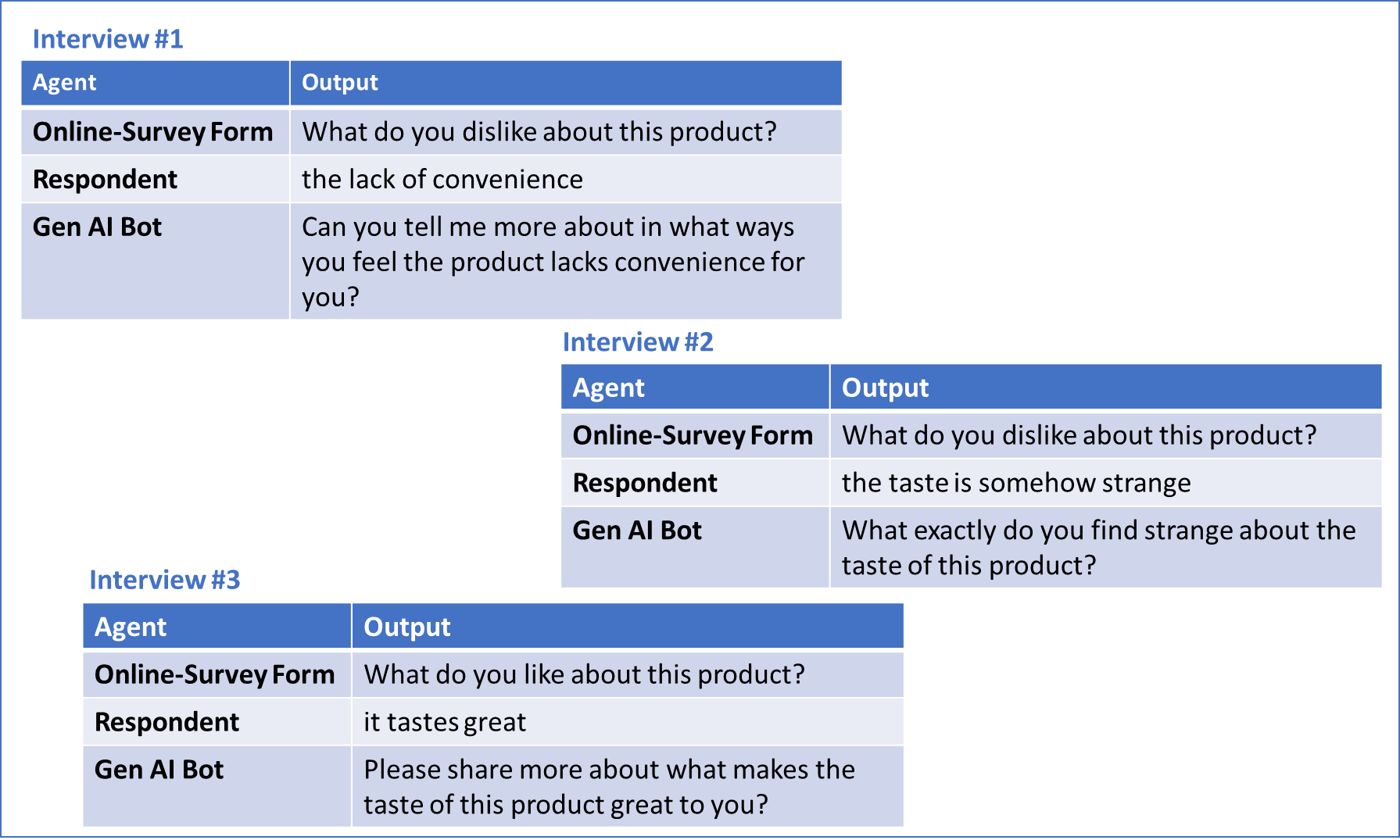

Offene Fragen in strukturierten Interviews liefern vertiefte Erkenntnisse zum «Warum?» hinter dem «Was?» der quantitativen Auswertungen. Mit einer gezielten Nachfrage kann eine Interviewerin differenziertere und detailliertere Antworten erhalten. Bei Online-Interviews war ein solches neutrales, motivierendes Nachfragen bisher kaum möglich. Generative KI hat das Potenzial, diese Aufgabe abwechslungsreich und ohne Suggestivfragen zu erfüllen. Als Input benötigt ein entsprechend trainiertes

Modell die ursprüngliche Frage plus die Antworten der Befragten. Die folgende Darstellung illustriert, wie ein solcher Dialog abläuft.

Ethik und Datenschutz

Viele Fragen der Ethik, des Datenschutzes und des Urheberrechts sind im Kontext der generativen KI noch nicht gelöst. Auch sind Urteile im Rahmen der neuen Gesetzgebung – insbesondere auch die Implikationen des EU AI Act – noch ausstehend. Markt- und Sozialforscherinnen tun deshalb gut daran, die bisherigen Grundsätze auch bei der Anwendung der KI zu befolgen, insbesondere die Anonymisierung der Daten zum frühest möglichen Zeitpunkt. Automatisierte Tools, die PII wie Namen oder Orte ausfiltern können, bieten dabei Unterstützung. Selbstverständlich muss die Weitergabe von individualisierten Erkenntnissen für Marketing-Zwecke weiterhin ausgeschlossen bleiben. Eine Herausforderung ist die Tatsache, dass die leistungsfähigsten KI-Modelle von OpenAI, Google und Anthropic auf Servern in den USA laufen. Dies ist in der Schweiz und in der EU trotz der Verfügbarkeit eines DPA (Data Processing Agreements) z. B. von OpenAI ein Problem. Als vorläufige Lösung können Modelle genutzt werden, die auf Schweizer oder EU-Servern laufen.

Der Autor

Dr. Stefan Oglesby ist Inhaber der data IQ AG und Gründer von insight-lab.ai, einer Plattform für die Analyse und interaktive Nutzung qualitativer Consumer Insights. Er hat langjährige Erfahrung in der qualitativen und quantitativen Marktforschung auf Auftraggeber- und Institutsseite.

Download Artikel

Swiss Insights News #24-8

Alle SWISS INSIGHTS News finden Sie hier: SWISS INSIGHTS NEWS